La Universidad de Deusto celebró el 26 de octubre un encuentro DeustoForum con Gemma Galdon Clavell, experta en ética tecnológica y responsabilidad algorítmica, que a través de su firma Eticas Research & Consulting trabaja con empresas, gobiernos y organizaciones de todo el mundo para corregir los sistemas de Inteligencia (IA) y hacerlos más eficientes e inclusivos.

Una inteligencia de la que todo el mundo habla, pero cuyo funcionamiento sigue generando hoy mucha confusión social. Y es que, tal y como explicó, si bien es cierto que estas tecnologías se nutren de las grandes bases de datos de la historia, las soluciones que aportan no son siempre las más óptimas ni objetivas. Ello se debe, según expuso, a que los algoritmos que las rigen procesan la información de manera selectiva, acorde a unos patrones de repetición que favorecen lo mayoritario y excluyen lo diferente, generando a su vez una nueva fuente de datos que retroalimenta el sistema.

Para Gemma Galdon, en el caso de los GPS, que entre diferentes alternativas priorizan las rutas más frecuentadas por los usuarios, o las plataformas de entretenimiento, que sugieren qué películas o series ver en base a un algoritmo que posiciona mejor los títulos con mayor número de reproducciones, el riesgo a correr en caso de error es menor, pero no así en aquellos ámbitos en los que la IA incide directamente en el análisis de la realidad y la toma de decisiones, ya que la eliminación de ciertos perfiles pueden acarrear consecuencias catastróficas. “Los algoritmos que rigen los sistemas de reconocimiento facial discriminan a personas con síndrome de Down, y las mujeres reciben entre un 10 y 20% menos de servicios bancarios porque en los sistemas de IA están infrarrepresentadas”, reveló.

Retos socio-técnicos

Al abordar temas complejos de manera automatizada y en base a indicadores que carecen de relevancia, la IA tiende a la simplificación y a la generación de errores y sesgos, algo que la auditoría algorítmica busca corregir, creando espacios de testeo que permitan entender cuáles son los riesgos reales antes de que lleguen a la población. Afirma, en este sentido, que “vivimos en una sociedad muy sesgada, y al igual que trabajamos para incorporar políticas que favorezcan la inclusión, es necesario establecer normas y entrenar a la IA en perfiles muy heterogéneos para aprovechar todo su potencial”.

De hecho, Gemma Galdon Clavell indicó que esos errores de la IA llegan a condicionar incluso la toma de decisiones en ámbitos sanitarios, educativos y laborales, con pacientes en salas de emergencias que son atendidos no en base a la gravedad de su patología sino por el coste de su intervención; profesores que ven valorado su desempeño según las tasas de éxito de su alumnado; o empresas en cuyas contrataciones la IA prevalece que sean jugadores de lacross.

Por lo tanto, la experta asegura que incorporar la ética a la IA es una cuestión innegociable para hacer frente a los retos socio-técnicos a los que nos enfrentamos, ya que tecnologías como Dalí o Chat GPT ponen de manifiesto las limitaciones de la IA, que más allá de reproducir patrones, no tienen la capacidad de aprender el lenguaje como lo hacen niñas y niños, ni de analizar objetivamente la realidad e innovar: “Si entramos en una dinámica de refritos de Chat GPT, ¿quién va a generar conocimiento e ideas nuevas?”.

La necesidad de abordar los riesgos de la IA ha creado un verdadero diálogo transnacional, que ya ha llegado a Europa, China e incluso la Casa Blanca, donde Eticas Research & Consulting está trabajando para generar un ecosistema innovador que fomente iniciativas que contribuyan a su regulación y acabe con las anomalías.

| Conferencia íntegra

| Vídeo resumen de los momentos más destacados

| Entrevista a Gemma Galdon Clavell realizada por Lorena Fernández Álvarez

| Entrevista a Gemma Galdon Clavell realizada por Peru Sasia

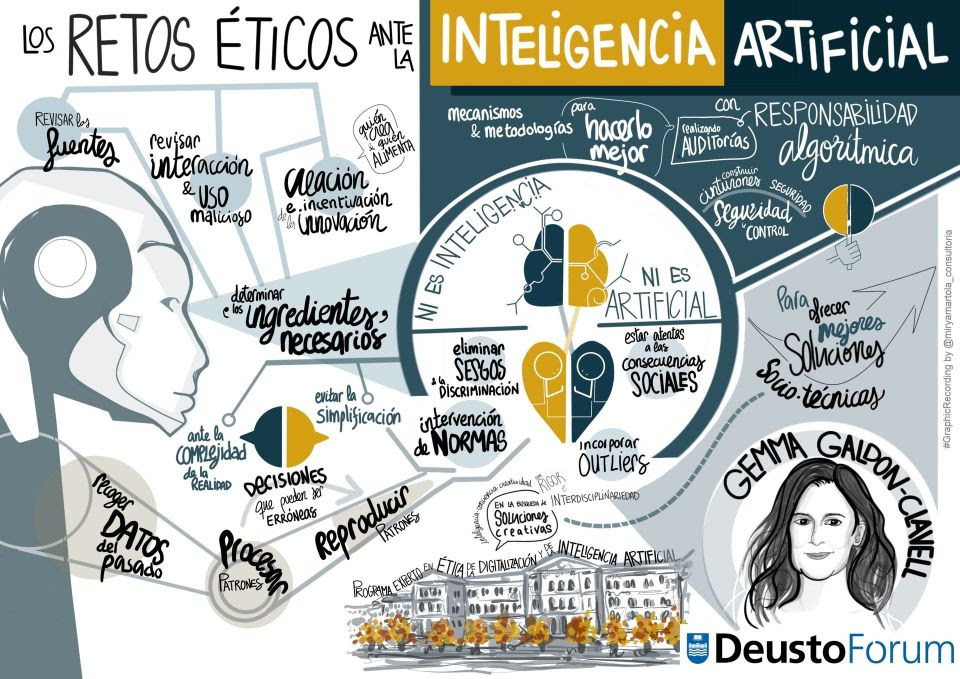

| Acta gráfica (Graphic Recording)

| Galería de imágenes

Leave a Reply