Artículo publicado en The Conversation (03/09/2023)

La inteligencia artificial (IA) ha irrumpido en lo que venimos llamando la sociedad de la información y el conocimiento. Numerosas industrias llevan los últimos meses realizando análisis urgentes acerca del impacto de la IA: desde las finanzas o las industrias creativas, hasta las administraciones públicas o la educación. Pero ¿cómo puede posicionarse el sector de la comunicación y, más específicamente, el periodismo, ante esta realidad?

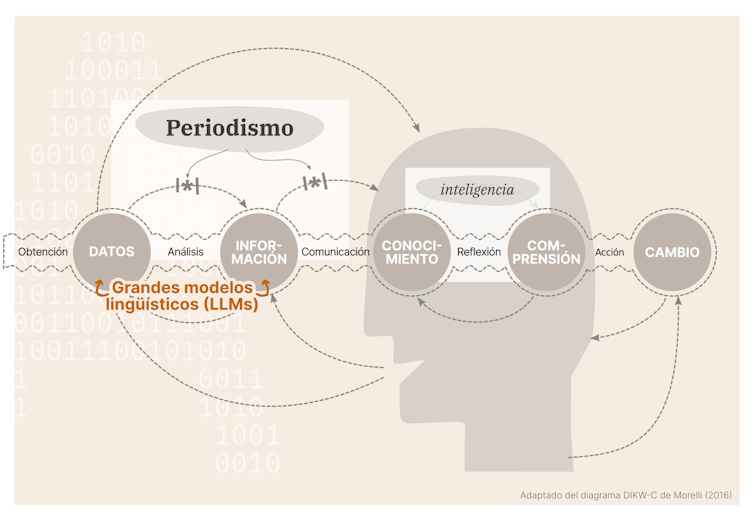

Resulta útil recuperar en este contexto un modelo acerca de cómo construimos el conocimiento que recibe distintos nombres: la pirámide o la jerarquía del conocimiento, o también el continuum de la comprensión. Explica que la organización y presentación de los datos es lo que permite transformarlos en información útil y significativa, que puede contribuir a generar conocimiento o incluso comprensión o sabiduría. El proceso puede continuar hasta la generación de cambio a través de la acción o la toma de decisiones.

Es relevante recalcar que todas las fases o elementos de este proceso mantienen relación con los anteriores y, en última instancia, con la realidad de partida. El proceso se fundamenta en la realidad y adquiere continuidad y sentido en contraste con ella.

Cómo usa la IA el lenguaje

En este modelo de generación de conocimiento, más allá de los datos o la información, el proceso es un fenómeno humano. A diferencia de las fases anteriores, que pueden externalizarse, transportarse y manipularse en otros soportes físicos como el papel o un disco duro, no es posible que la reflexión o el pensamiento, ni por tanto el conocimiento, la comprensión o la inteligencia, ocurran fuera de la mente humana.

En todas estas transformaciones, el lenguaje juega un papel esencial. El análisis o la organización de los datos están marcados por la sintaxis del idioma, y esta, por tanto, condiciona en cierta medida las posibilidades disponibles para esa estructuración. La lengua es también el vehículo principal de comunicación. Gran parte del proceso de reflexión se articula también a través del lenguaje.

Las herramientas como ChatGPT se conocen también a través del término más específico y adecuado “modelo lingüístico” (LLM, o large language model en inglés). Este tipo de robots basados en chats hacen una creación lingüística probabilística y solamente aparente. Proponen qué palabras son las más probables después de cualquier otra palabra dada, basándose en grandes bases de datos, pero no realizan ningún contraste con la realidad.

El lenguaje, en tanto que abstracción e interpretación de la realidad, solamente funciona si tenemos unos referentes comunes y compartidos sobre la relación entre significante y significado, entre la palabra y el referente. En ausencia de este mínimo consenso, el diálogo o la discusión se convierte en un “diálogo de besugos”.

Los modelos lingüísticos, a pesar de su nombre, no manipulan significados ni, tras haber generado comprensión y conocimiento, comunican relatos en torno a esas ideas, como hacemos en los procesos de comunicación humana. Actúan con mera forma, solo con referentes, solo con significantes. Son capaces de generar lenguaje de apariencia humana, pero totalmente carente del significado que los humanos manejamos al hacer generaciones de lenguaje parecidas.

No tiene las características de la inteligencia humana

Y sin embargo, cuando usamos términos como “inteligencia” para referirnos a modelos lingüísticos como ChatGPT, otorgamos cierta visión antropomórfica a un algoritmo, y le asignamos, quizá inconscientemente, algunas características de la inteligencia humana. Asumimos que son capaces de comprender, de manejar significados o, en términos más lingüísticos, de referirse a referentes mediante el lenguaje que generan.

Otros muchos términos que utilizamos (que se han extendido, que se han difundido) en este contexto presentan el mismo problema: se habla de “entrenamiento”, o de “aprendizaje”, o de “alucinaciones”. Cuando hacemos referencia con estos términos a lo que hace ChatGPT, automáticamente nos viene a la mente un entrenamiento humano, el aprendizaje humano o las alucinaciones humanas; y asignamos a estos instrumentos las características de esas experiencias humanas. Sin embargo, esta representación es una ilusión.

Una contribución más a la desinformación

Ante esta oleada de modelos lingüísticos cada vez más sofisticados, ¿siguen siendo relevantes las profesiones relacionadas con la comunicación, como el periodismo? La contribución de la IA al panorama parece ser, sobre todo, en forma de fake news y desinformación, con imágenes generadas por IA cada vez más difíciles de distinguir de las reales.

El periodismo es un tipo de comunicación con una función social específica: “Proporcionar a la ciudadanía la información que necesita para ser libre y gobernarse a sí misma”. Este propósito requiere un compromiso con la verdad que podemos entender como una representación honesta de la realidad. Por otro lado, en casi todos los diccionarios la mentira o lo que es falso se define mediante la negación de la verdad. En este sentido, la mentira reconoce cierta legitimidad a la verdad, la necesita para posicionarse como su contraria.

En el contexto actual de posverdad, más que fake news o noticias de mentira, lo que vemos se parece más a un completo desinterés por cualquier relación del relato con un referente real, más cercano a la charlatanería o el “trastorno informativo”.

Independientemente de si lo comunicado es verdad o mentira, en la posverdad el foco está en manipular creencias y emociones con el fin de influir en la opinión pública y en actitudes sociales. Vivimos un momento de desprecio a la importancia de la verdad de lo que es real.

En este contexto, que los modelos lingüísticos o lo que llamamos “inteligencias artificiales” no manejen ningún referente real o contraste con la realidad no resulta problemático. No es, por tanto, que ChatGPT mienta, o que invente, es que no tiene una noción de lo que es mentira (o lo que es verdad). Pero sí que las IA pueden convertirse en importantes fuentes de desinformación.

ChatGPT no va a reemplazar al periodismo en su función social porque no nos ofrece interpretaciones de la realidad que nos ayuden a tomar decisiones. Pero al mismo tiempo, las IA complican enormemente que el periodismo pueda cumplir su propósito, al reforzar un paradigma de desprecio al valor de la verdad.

El periodismo debe reafirmarse

¿Cuál es el papel del periodismo, entonces, con respecto al avance de la inteligencia artificial? El primero, desde luego, debe ser reafirmarse en su función y resistirse a la fascinación generada por la IA.

La imagen que nos hemos construido de ChatGPT en particular y de las capacidades de la IA en general es, en gran medida, la que se esfuerzan en transmitir sus creadores: nos ha atrapado el asombro que nos han querido provocar.

Esa fascinación desactiva el olfato periodístico y la exigencia de rendir cuentas a las partes interesadas. En lugar de aceptar que la amenaza de la IA es existencial y pone en peligro al género humano en su conjunto, podríamos centrarnos en que las IAs actuales son sistemas inmaduros que en cualquier otra industria ni siquiera se habrían autorizado para comercializarse. Si, como plantea el escritor y bloguero Cory Doctorow, aceptamos que “no se debería confiar en ellos para pilotar drones o conducir coches (…) o determinar tu solvencia o tu asegurabilidad, entonces todas esas empresas de IA estarán en la quiebra”.

El periodismo tiene la capacidad y el deber de entender y explicar estas herramientas como lo que son y observar las limitaciones que presentan y los problemas y daños que están causando ya (como los sesgos discriminatorios, el impacto medioambiental o la explotación laboral).

Es urgente que se planteen las preguntas verdaderamente importantes, aquellas para las que necesitamos respuesta, en lugar de dejarse llevar por la fascinación de esta idea mística de la IA.

Deja una respuesta