Esta es la versión completa de una entrevista con Miren Gutiérrez, Directora del Programa de Comunciación de Datos, con David García-Maroto (@David4210) en El Independiente publicada hoy.

Estoy elaborando un reportaje sobre el perfil laboral ‘de moda’, el de analista de datos. Quería saber con detalle en qué consiste..

Es el o la especialista en los procesos de obtención, limpieza y análisis, y a veces visualización, de datos utilizando razonamiento y herramientas analíticas. Existe una variedad de métodos de análisis de datos específicos, algunos de los cuales incluyen obtención de datos, análisis estadístico, análisis de redes mediante teoría de grafos, análisis de texto y de sentimientos, inteligencia artificial y visualizaciones de datos. Cada punto en la cadena de valor del dato puede generar una especialización.

Cómo se forma un analista de datos

Depende para qué. Yo dirijo un postgrado en Deusto que se dedica a facilitar herramientas accesibles, no solo tecnológicas, sino también legales, estratégicas y sobre todo de comunicación para abordar cualquier proyecto de datos.

Pero depende. Si estamos hablando de grandes proyectos con big data, entonces una sola persona, por muy formada que esté, no es suficiente. Generalmente se trabaja en equipo, en los que buscas una mezcla de competencias y conocimientos de la industria que se esté estudiando.

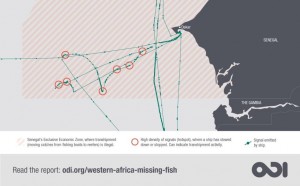

Por ejemplo, un estudio un estudio de las principales plataformas big data dedicadas a observar la pesca, que acabo de publicar con el Overseas Development Institute, indica que, aunque ofrecen grandes oportunidades para la vigilancia de la pesca, aún hay mucho camino por delante. Desde la liberación del mercado de los datos satelitales hace más de una década, han ido surgiendo plataformas de datos privadas dedicadas al seguimiento de los barcos pesqueros de cierto tamaño, obligados por seguridad a emitir señales regularmente mientras están operativos. Pero el informe del ODI destaca graves fallas en estas plataformas privadas. Por ejemplo, un tercio de los 75,000 buques de pesca que figuran en la plataforma Global Fishing Watch respaldada por Google en el momento en el que investigábamos son duplicados o buques que no participan en la pesca.

Para ese tipo de proyectos se confía en profesionales que han hecho una carrera universitaria o tienen una gran experiencia escribiendo código y trabajando con inteligencia artificial. Pero también deben integrar equipos que sepan de la industria para no caer en errores como los que indicaba antes. Si te fías solo del algoritmo, éste puede identificar como barco pesquero a otro, por ejemplo uno que carga bananas, porque tiene algún comportamiento comçun con un pesquero, que es lo que le pasó a Global Fishing Watch. Hace falta saber mucho conocimiento de las industrias para hacer informes certeros y poder interpretar bien los análisis de grandes datos.

¿Qué aplicaciones tiene?

Los sectores que hasta ahora han maximizado el análisis de datos son algunas agencias gubernamentales, sobre todo en cuestiones de vigilancia masiva, y el sector privado, a veces trabajando juntos, como se vio en las revelaciones de Snowden en 2013, quien reveló que Verizon y otras telefónicas habían estado proporcionando datos de sus clientes, sin su conocimiento, a la agencia de seguridad nacional.

Como investigadora estoy más interesada en cómo se usa la infraestructura de datos, entendida como los procesos, el hardware y el software necesarios para analizar datos y extraer valor, en la sociedad civil y el periodismo.

Pero hay aplicaciones en todos los sectores. Por ejemplo, el estudio de archivos históricos, que están gradualmente digitalizándose. Un ejemplo es la edición en coreano del siglo XIII del canon budista, que incluye 52 millones de caracteres distribuidos en 166.000 páginas. Examinado con métodos tradicionales, se tenían que recurrir al análisis selectivo de fragmentos. Hoy en día la infraestructura de datos permite el estudio integral con enorme precisión de casi cualquier corpus documental digitalizado; e impulsa un cambio en la investigación, en la que ahora cobra mucha más importancia la validación de las fuentes, y las formas de comunicar conocimiento.

De las cosas más interesantes que he visto hacer con datos es el mapa de Forensic Architecture llamado Liquid Traces en el que visualiza la deriva de un barco con 72 emigrantes durante 14 días en las costas de Libia. Solo sobrevivieron 9. El mapa, basado en las mismas tecnologías de visualización de señales del Sistema de Identifiación Automática AIS, demuestra que diversos barcos de Frontex y NATO los vieron y no hicieron nada.

¿Qué empresas demandan estas competencias?

Todas. Aunque la pregunta sería qué empresas u organizaciones las necesitan y cuáles las demandan. Hay mucha necesidad en el tercer sector, pero no necesariamente se traduce en demanda. Por ejemplo, me cuenta la directora de DataKind UK, una organización que se dedica a colocar científicos y científicas de datos en ONG, que no le faltan voluntarios y voluntarias dispuestos a trabajar pro bono en una ONG, pero que no hay tantas ONG que tengan la capacidad de absorber esta capacidad y conocimiento.

Hace poco celebramos una conferencia en Madrid con representantes de organizaciones que financian proyectos sociales con datos, que los facilitan que generan plataformas y herramientas, y que hacen periodismo y activismo de datos, y una de las conclusiones que los datos pueden generar cambios sociales pero las organizaciones también deben transformarse.