(Artículo escrito por Izaskun Larrea, alumna de la promoción de 2017 en el Programa en Big Data y Business Intelligence en Bilbao)

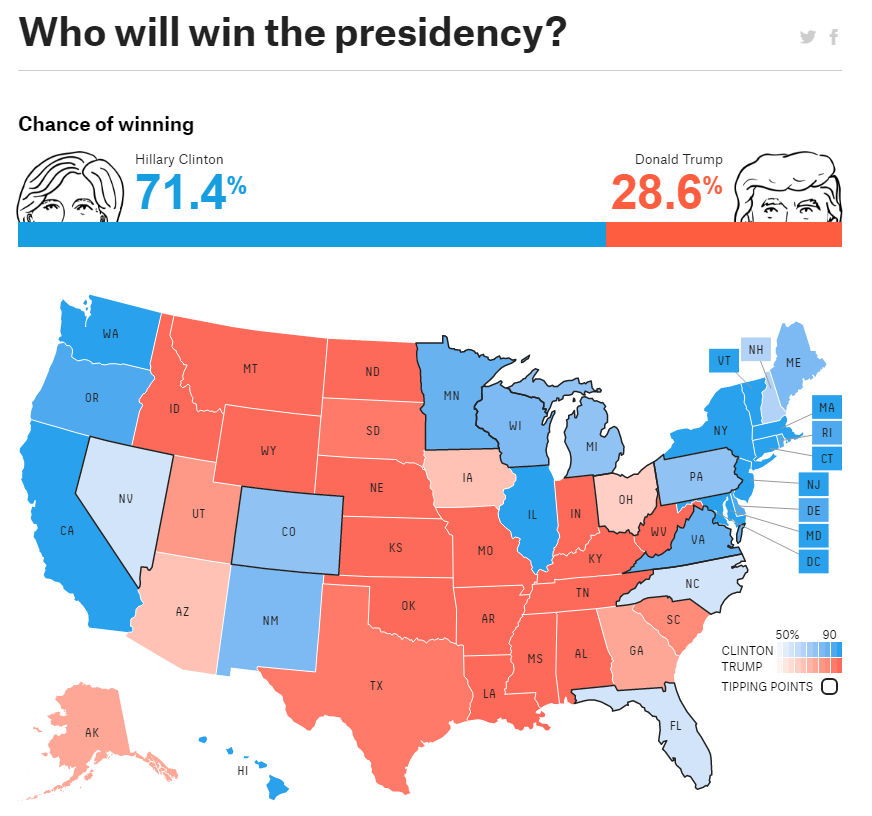

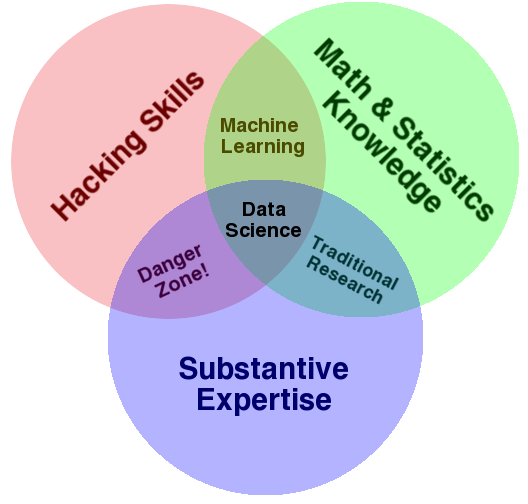

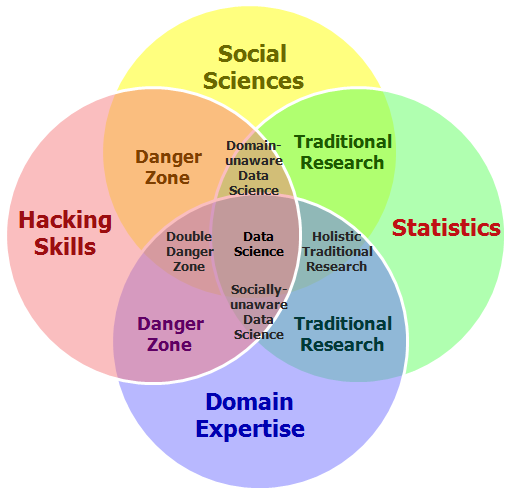

¡Hacer predicciones no es suficiente! Los científicos de datos eficaces saben explicar e interpretar sus resultados y comunicar los hallazgos con precisión a las partes interesadas para tomar decisiones empresariales. La visualización es el campo de investigación que estudia la comunicación efectiva de resultados cuantitativos vinculando percepción, cognición y algoritmos. Es necesario aprender a reconocer, diseñar y utilizar visualizaciones efectivas.

Como Data Scientist debemos explorar las consideraciones éticas sobre el Big Data y cómo estas consideraciones están comenzando a influir en la política y en la sociedad. Tenemos limitaciones en el uso de la tecnología para proteger la privacidad y los códigos de conducta que emergen para guiar el comportamiento de los científicos de los datos.

Las inferencias estadísticas del Big Data, heterogéneos y ruidosos son inútiles si no puede comunicarlos a sus colegas, a sus clientes, a su administración y a todas las partes interesadas, parece ir paradójicamente empeorando. Pero la reproducibilidad no es sólo para los académicos: los científicos de datos que no pueden compartir, explicar y defender sus métodos para que otros puedan construir son difíciles de entender. La importancia de la investigación reproducible y cómo el cloud computing está ofreciendo nuevos mecanismos para compartir código, datos, entornos e incluso costos que son críticos para la reproducibilidad práctica.

Últimamente, he trabajado en una serie de proyectos que requieren la recapitulación del Big Data para desarrollar materiales de comunicación que transmiten mensajes clave con claridad y precisión.

Si bien el tipo y la cantidad de datos, las áreas temáticas y el público objetivo de cada pieza de comunicaciones varían, cada proyecto implica el uso de los siguientes pasos para producir piezas de comunicaciones efectivas en el Big Data:

- Evaluar la exactitud de tus datos. Ya sea porque esté explorado en Internet, interpretando un informe técnico de 100 páginas, analizando los datos de demostración reportados por el usuario o resumiendo los resultados de un trabajo, es importante hacer preguntas sobre tus datos. ¿Tus fuentes proporcionan información conflictiva que es contraria a lo que esperabas? Si es así, haz un poco de investigación adicional para resolver estos problemas y excluir cualquier fuente no confiable.

- Analizar lo que dice la información – Ahora que sabes que tus datos son más precisos, es el momento de organizarlo en categorías lógicas. ¿Cuáles son los principales bloques de información con los que se trata? ¿Tienes información cualitativa y cuantitativa? Una vez que tengas una mejor comprensión de la profundidad y amplitud de tus datos, puedes resumir con mayor facilidad los puntos clave de cada agrupación de datos.

- Determinar lo que es más importante para tu audiencia – Es fácil resumir todos los datos con los que estás trabajando, pero algunos datos son más importantes para tu audiencia que otros. ¿Alguno de tus puntos clave fue sorprendente o nuevo? Trate de encontrar tus puntos clave, preguntarse qué es significativo y por qué cada punto importa. Si tú no puedes llegar a una respuesta, es probable que el punto clave no debe ser incluido.

- Identificar el formato más significativo para la presentación de tus datos – Para aumentar la eficacia de tu análisis, este paso debe estar realmente en tu mente durante todo el proceso del análisis de datos. Es importante determinar qué formato de comunicaciones será más útil para tu audiencia, para que tu proyecto inspire acción en lugar de simplemente una exposición de información masiva. ¿Es probable que tu público realice físicamente un resumen ejecutivo o una hoja informativa? ¿Es probable que eliminen las páginas o el capítulo de un informe que más se relaciona con tu investigación? El propósito de la información debe determinar el formato de tu informe. Y por supuesto, no olvides que vivimos en una edad muy visual. Debemos de usar señales visuales para comunicar temas complejos.

Un análisis de datos eficaz requiere hacer el trabajo desde abajo para que nadie más en la organización se atasque con el Big Data. Tu audiencia no tendrá tiempo para luchar para determinar qué información es más importante. Es tu trabajo interpretar los datos para ellos.