En el workshop que organizamos el pasado 27 de Octubre, también participó CIMUBISA, entidad municipal del Ayuntamiento de Bilbao. Básicamente, nos habló sobre la formulación estratégica de ciudad que tenía Bilbao, y cómo el Big Data impactaba sobre ella.

CIMUBISA expuso la formulación estratégica de ciudad que tiene Bilbao. Una estrategia que gira en torno a 5 ejes de actuación:

- Administración 4.0

- Tecnologías en el espacio urbano

- Ciudadanía digital y calidad de vida

- Desarrollo económico inteligente

- Gobernanza

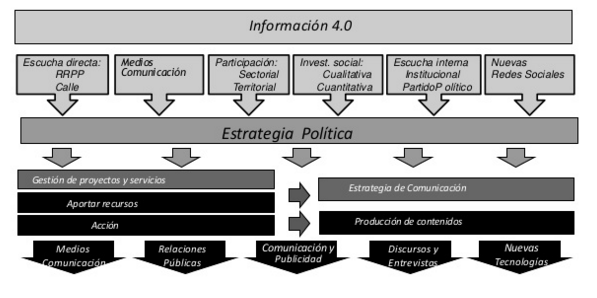

Y en esta estrategia, el dato, la información, resultan clave para ayudar a decidir. No podemos construir una administración inteligente sin una información de calidad para tomar decisiones que beneficien a la sociedad en su conjunto. Prueba de ello es la representación esquemática que se muestra a continuación, en la que la estrategia política, se artícula en torno a diferentes fuentes de información, que la estrategia «Smart City Bilbao» procesa y pone en valor. Fuentes como la escucha directa en la calle, lo que los medios de comunicación señalan sobre la ciudad, lo que se obtiene del fomento de la participación, investigaciones cuantitativas y cualitativas, escucha institucional interna, redes sociales, etc.

¿Y con todos estos datos recogidos que se hace en Bilbao? Un análisis descriptivo, predictivo y prescriptivo. Es decir, técnicas de data mining para extraer más información aún de los datos ya capturados. Un carácter descriptivo para saber lo que pasa en Bilbao; un carácter predictivo para simular lo que pudiera pasar en Bilbao cuando se den unos valores en una serie de variables; y un carácter prescriptivo para recomendar a Bilbao en qué parámetros se ha de incidir para mejorar la gestión y la administración en aras de maximizar el bienestar del ciudadano.

En última instancia, esos datos capturados y tratados con carácter descriptivo, predictivo y prescriptivo, es visualizado. ¿De qué manera? Gráficos, tablas, dashboards, mapas de calor, etc., en áreas como la movilidad y el tráfico, la seguridad y emergencias, la gestión de residuos, eficiencia energética, etc.

Por último, nos hablaron del proyecto Big Bilbao, un nuevo concurso que aspira a posicionar a Bilbao en el mapa en esto del Big Data. Un proyecto transformador de inteligencia de ciudad. El principal objetivo de este proyecto es crear una plataforma que permita explotar datos de distintas fuentes, estructurados y no estructurados, que permitan mejorar la eficiencia de la gestión de la ciudad. Es decir, una smart city con funcionalidades avanzadas y de altas prestaciones.

Con todo esto que hemos explicado, no nos debe extrañar lo que ya citamos en el artículo sobre ciudades inteligentes; Bilbao, fue la primera certificada UNE como Ciudad Inteligente o Smart City.

Os dejamos la presentación para terminar este post, por si quisieráis extender los detalles sobre lo descrito anteriormente.