@gutierrezmiren*

Se puede tener una gran capacidad algorítmica, pero si no se tienen los datos adecuados o el conocimiento de la industria al que aplica, esta capacidad no ofrecerá buenos resultados.

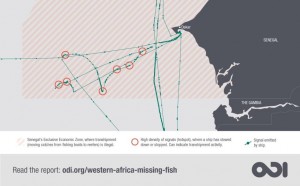

Esta es la conclusión de un estudio comparativo publicado por el Overseas Development Institute sobre las plataformas big data que usan datos satelitales y de registros públicos para tratar de visualizar y combatir la pesca ilegal. Pero esta conclusión se podría aplicar a cualquier estudio.

La pesca es un campo que genera una gran cantidad de datos. Los buques pesqueros de un tamaño determinado están obligados a inscribirse en diversos registros y, mientras operan en el mar, deben emitir regularmente señales que transmiten sus movimientos. Estas señales son capturadas por otros barcos, estaciones terrenales y satélites.

A través de análisis de bases de datos, así como de encuestas y entrevistas con las cinco principales organizaciones dedicadas al big data sobre la pesca, el último informe del ODI de Londres, del que soy coautora, revela que el potencial que tiene la infraestructura de datos para el monitoreo y estudio de la pesca está siendo socavado por el limitado tamaño y la mala calidad de las bases de datos que se han diseñado hasta ahora para identificar comportamientos irregulares en alta mar.

Para empezar, nadie sabe cuántos barcos de pesca hay en el mundo; y menos qué es lo que están haciendo. Esto dificulta la lucha contra la pesca ilegal.

Pesca ilegal

La pesca ilegal, no declarada y no regulada (conocida por sus siglas en inglés IUU) representa hasta una quinta parte de la captura pesquera mundial, con un valor de entre $10.000 millones y $23.500 millones anuales. Además, cada vez hay más pruebas que relacionan la pesca ilegal con el tráfico de personas y drogas, la corrupción y el lavado de dinero.

También se sabe que tiene un impacto negativo en la seguridad alimentaria, la creación de empleo y el desarrollo de las comunidades costeras en general.

A pesar de las posibilidades que ofrecen los big data para el monitoreo de la actividad pesquera, el movimiento contra la pesca ilegal aún no ha adoptado la llamada revolución de datos.

Una gran cantidad de datos disponible

Según la Organización de las Naciones Unidas para la Agricultura y la Alimentación (FAO), hay aproximadamente 4.6 millones de buques pesqueros, pero la mayoría son pequeños y artesanales. Normalmente, a cada buque de cierto tamaño le pueden corresponder 120 tipos de información, y durante su vida útil puede acumular varios valores en cada campo cada vez que cambia de empresa propietaria, armadora, bandera o nombre. Además, se requiere que todos los barcos pesqueros de más de 15 metros emitan, cada pocos minutos, señales que contengan (entre otra información) la hora, su longitud y latitud.

En consecuencia, existe una gran cantidad de datos sobre embarcaciones pesqueras. Con la aparición de servicios satelitales hacia 2010, estos datos están ahora disponibles comercialmente.

Sin embargo, el informe de ODI destaca que los países desarrollados y las organizaciones multilaterales han tardado en explotar la oportunidad que esto presenta. En lugar de crear una única herramienta de información sobre la flota pesquera mundial, los datos están dispersos en una gran cantidad de registros diferentes. La falta de una única base de datos hace que la detección de la pesca ilegal sea difícil.

La necesidad del análisis de «grandes datos»

El análisis de datos puede compensar la falta de recursos disponibles para patrullar los océanos. Por ejemplo, el primer informe de transbordo de pescado basado en datos, publicado por ODI en 2016, mostró indicios claros de que algunos buques refrigerados que recogen pescado en alta mar para su transporte a los mercados importadores estaban involucrados en operaciones irregulares nunca detectadas previamente.

El ireciente nforme defiende alianzas más sólidas y colaborativas entre los responsables de los datos sobre la pesca . También existe la necesidad de una mejor gobernanza pesquera global. Esto incluye esfuerzos más importantes para combatir la corrupción y las prácticas ilegales, como el uso de pabellones de conveniencia y acuerdos secretos de pesca.

La efectividad de las iniciativas destinadas a lidiar con la pesca ilegal dependerá de la solidez de los datos, de la facilidad con la que se pueden obtener y de nuestra capacidad para interpretarlos en función del conocimiento de la industria. Sin una base de datos única y unificada de la información disponible, la lucha contra la pesca ilegal será una batalla cuesta arriba.

*gutierrezmiren es Directora del Programa de postgrado «Análisis, investigación y comunicación de datos» y profesora de Comunicación de Deusto. Es también investigadora del Overseas Development Institute de Londres y de Datactive de Amsterdam.