Hace unos meses (el Enero pasado), hablábamos de la medicina 5P. El cruce entre la sanidad y el Big Data, donde aparecían conceptos y ventajas como la Personalización, Predicción, Prevención, Participación y Población. En términos de la personalización, decía lo siguiente:

Personalizada: el eterno sueño de la medicina. Poder dar un tratamiento singular al diagnóstico y necesidades concretas de cada uno de los pacientes. Con el Big Data, la cantidad ingente de datos, y el contexto que describe a cada uno de los pacientes, esto es posible. Solo es cuestión de “codificar” en datos lo que hasta ahora no hemos hecho, en cuestión de aspectos clínicos como estado de ánimo, emociones, expresión del dolor, etc.

La personalización de la prestación de un servicio es algo que ha venido inexorablemente ligado a esta era del Big Data. Si lo pensamos por un momento, tiene todo el sentido del mundo. Una reciente encuesta de Infosys, decía como el 78% de los consumidores estaría dispuesto a repetir la compra con una marca si se le personalizaba la propuesta de valor. Otro informe de RightNow Customer Impact, ilustraba la idea de la personalización desde la óptica de más ventas para una marca: un 86% de los consumidores estaría dispuesto a pagar más si la personalización se refería a sus necesidades.

Por lo tanto, hay margen y posibilidad de ganancia en la era de la personalización. Sin embargo, no es un proyecto fácil, por mucho que veamos muchos textos hablando de ello. Y es que hasta la fecha, nos costaba mucho personalizar los servicios por varias cuestiones:

- No era rentable

- El consumidor tampoco lo demandaba

- No teníamos información para hacerlo

Pero ahora, estos tres elementos se desvanecen. Han cambiado. Las posibilidades ahora se multiplican, gracias a que con la ingente generación de datos, el reto está más relacionado con saber sacar valor de los datos que de no tener información para ello. Sin embargo, todavía queda mucho por hacer. Solo el 20% de las acciones de marketing llevan ligadas características de personalización. Esto es solo un ejemplo de un «área», donde la personalización tiene mucho que aportar.

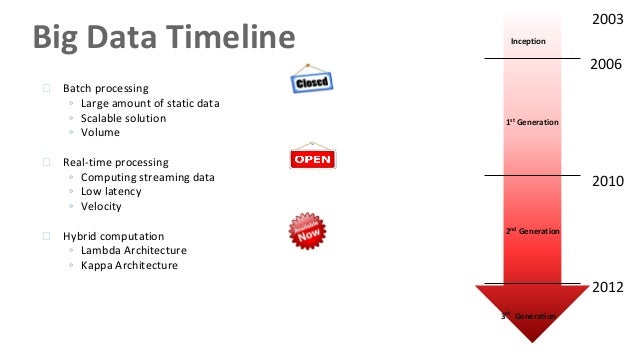

Y más en el campo sanitario, donde las ineficiencias, o donde la no-personalización de la aplicación de algún fármaco, puede traer importantes consecuencias. Miremos la siguiente figura:

En la entrada de la Wikipedia en Español, la definición de «Medicina Personalizada«, hace referencia a varias cuestiones que me parecen bastante ilustrativas de lo que hoy queremos hablar:

- Administración de un fármaco o conjunto de fármacos más idóneos

- En las dosis adecuadas para cada paciente concreto

- A la vista de su individualidad química y genética

- Se apoya tanto en el conocimiento de la naturaleza molecular de las enfermedades como en la individualidad química que posee cada paciente

Sin embargo, la entrada de la Wikipedia en Inglés ofrece otra serie de elementos que describen de una manera más global y multidimensional el concepto de «personalización», en este caso, para la medicina:

- Modelo médico

- Toma de decisiones y prácticas basadas en la personalización y las características individuales de cada paciente

- Uso sistemático de información genética del paciente

Es decir, habla más de muchos de los elementos que hemos venido citando necesarios para los proyectos de Big Data: una buena materia prima, una transformación de los modelos (de negocio u organizativos), una toma de decisiones basada en la evidencia, etc. Y son cuestiones que vemos en nuestros Programas de Big Data, no solo para la medicina, sino también en otras cuestiones (ofertas publicitarias, planes de carrera personalizados, recomendaciones de productos en tiendas online, etc.). Por eso he señalado en negrita los aspectos más relacionados con esto de la «era de la personalización«.

Y todo esto, tiene aplicación en toda la cadena de valor del sector de la salud, no solo en la prestación médica. Y tiene aplicación en otros sectores. Porque el sector sanitario en cierto modo me recuerda a cuando el sector de las telecomunicaciones o las utilities pasó de un modelo de abonado a un modelo de cliente. Una transición que se hizo realmente mal (más allá de la privatización + poca liberalización de España). Los clientes, por el trato recibido, mostraron su poca satisfacción cambiando constantemente de operador (es un sector con un CHURN muy elevado), y ve estos servicios como commodities. Y por eso, también en nuestros programas de Big Data diseñamos y desarrollamos modelos predictivos de propensión a la fuga (CHURN).

En el sector sanitario, el concepto «Consumer Driven Healthcare» hace un poco referencia a todo ello. Los ciudadanos toman un rol activo en la gestión de su salud y están dispuestos a pagar por ello. Se le da: decisión, información y control. Y, de nuevo, hablamos de poner al cliente -el paciente en este caso- en el centro del proceso.

En todo esto, y como solemos concluir muchos artículos, nunca debemos abandonar la ética. Y menos en un campo tan sensible como es el sanitario.