En esta era de la personalización, del consumidor exigente, una cosa que obviamos es que sí, las empresas saben más de nosotros que nunca. Y quieren saber cada vez más. Según el estudio The Talent Dividend, elaborado por la revista MIT Sloan Management Review y la empresa de software analítico SAS, basado en entrevistas a 28 ejecutivos de firmas internacionales y encuestas a 2.719 empleados, el 50% de las compañías asegura que entre sus prioridades está aprender a transformar los datos en acciones de negocio.

¿Sabemos realmetne lo que hacen las empresas con nuestros datos e información? ¿Cómo la protegen? ¿Qué hacen con ella? ¿La venderán? ¿Cumplen con lo que nos dicen? Datos que vamos dejando sin daros cuenta cada vez que hacemos una búsqueda en Google, cada vez que compartimos un tweet, un post, una fotografía en Instagram o un comentario en Facebook. Por poner solo varios ejemplos.

Cuando de forma voluntaria accedes a compartir datos con tus apps, parece de justicia, que el uso de esa información te traiga ciertos beneficios. De ahí, podemos decir que es importante que te digan qué harán con esa información. Por todo ello, aparecen las preocupaciones por la privacidad. En Europa, es algo que nos preocupa. Por eso también saber dónde dejamos esos datos: si es un proveedor americano, ¿está en Europa también? ¿o los manda para EEUU automáticamente?

Para resolver todas estas inquietudes y preguntas abiertas, el grupo de trabajo del artículo 29, un organismo consultivo de la Comisión Europea, se dedica a efectuar recomendaciones en materia de privacidad.

El pasado 2014, elaboró una opinión (Dictamen 8/2014), sobre los riesgos a la privacidad de este mundo conectado. Esas líneas de reflexión, posiblemente generen regulaciones futuras, y se centraban en dos elementos: «privacy by design» y el «security by design«. ¿Qué es esto?

Básicamente, se trata de un enfoque que aboga por la privacidad y la necesidad de tener en cuenta la seguridad en el mismo momento del diseño de los objetos inteligentes. Es decir, en lugar de tener que hacer este ejercicio de protección y seguridad a posteriori, hagámoslo antes de fabricar los objetos.

Este enfoque está ganando especial relevancia ante el previsible auge de los objetos conectados a Internet. Es decir, el paradigma Internet of Things. Cuando estemos interaccionando a través de Internet con «todos» los objetos que nos rodean (el microondas, el coche, el teléfono móvil, el autobús, la tarjeta de crédito, etc.), obviamente, la cantidad de datos que vamos a generar va a ser aun mayor que la actual. Es por ello, que tenemos «Big Data» para rato. Pero también debemos tener preocupación por la privacidad de los datos que generamos, y sobre todo, hacerlo en un marco de seguridad.

Pues bien, este Grupo de Trabajo del artículo 29, habla del Privacy y Security by design como una forma de enfocar el diseño y desarrollo de los objetos conectados a Internet de los que nos rodearemos a futuro. Y me ha parecido especialmente relevante citar estas cuestiones debido a que el software que deberemos desarrollar para poner en valor esos datos, deberá cumplir estos principios también.

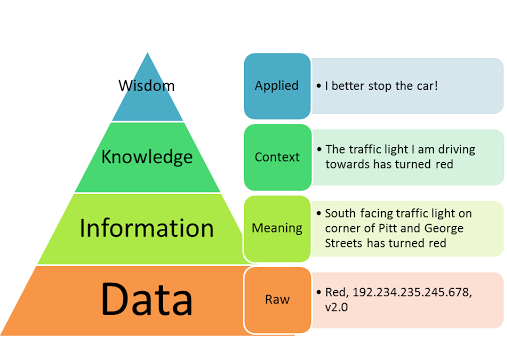

¿De qué estamos hablando? Básicamente, de la protección de datos y de aspectos relacionados como:

- El Dictamen plantea tres escenarios donde se debe prestar especial atención:

- Tecnología para llevar puesta (wearable computing)

- Dispositivos capaces de registrar información relacionada con la actividad física de las personas

- La domótica

- Los objetos que recogen datos relacionados con la salud y el bienestar del ciudadano, pese, a ser anónimos en un principio, pueden revelar aspectos específicos de hábitos, comportamientos y preferencias, configurando patrones de la vida de las persona (con los consiguienres riesgos morales que puede suponer).

- Recomendaciones de utilidad en el desarrollo de estándares tecnológicos en el ámbito del Internet de las Cosas (y así evitar problemas para el usuario a la hora de querer cambiar de un contexto a otro)

- Alerta que el usuario puede perder el control sobre la difusión de sus datos si la recogida y el procesamiento de los mismos se realiza de manera transparente o no (la importancia de tener claro el marco donde serán tratados esos datos)

- Manifestar claramente que la información personal sólo puede ser recogida para unos fines determinados y legítimos

Considerando estos aspectos antes de empezar el diseño y fabricación de un objeto, el dictamen asegura que evitaríamos muchos problemas y retos legales y éticos que tenemos en la actualidad.

Ya ven, de nuevo, que la era del Big Data, además de que nos vaya a dar mucho trabajo a futuro, también chocará con los marcos normativos. Por eso es importante también considerar enfoques tan novedodos como el «Privacy y Security by design«, y así evitar limitaciones de diseño y desarrollo a futuro, chocando con el ámbito jurídico.