(Artículo de nuestro profesor Jonatan Belarde, en el Programa en Big Data y Business Intelligence)

En el módulo de negocio del Programa de BI y Big Data hacemos un ejercicio con los alumnos. Les proponemos transformar una industria, a priori tradicional, en un modelo de negocio totalmente diferente, gracias al uso de los datos. A lo largo de las tres ediciones hemos transformado negocios tan diversos como la apicultura, la distribución de contenidos, franquicias para despiojar o peluquerías.

Uno de los casos habituales es la transformación de una OEM de automoción (fabricante de automóviles), una industria cuya transformación se acelera con las evoluciones hacia los vehículos eléctricos y autónomos. Pero esta industria tiene más cambios que abordar. A los alumnos les preguntamos, ¿cómo imaginas el mundo dentro de 10 años? ¿Y cual es el papel que ocuparían los actuales fabricantes de vehículos sabiendo que cada vez se van a vender menos vehículos y habrá más competidores?

Lo habitual es recurrir a las fórmulas en auge como el carsharing, pero pensemos en la movilidad como si fuera un servicio (Maas) y en el coche como si fuera un smartphone, el dispositivo a través del cual interaccionamos con otras aplicaciones y servicios mientras viajamos, conduciendo o no.

Entrando en otras industrias

Esta es la gran pregunta que se están haciendo los fabricantes de vehículos, ¿en qué industrias puedo incursionar gracias a los datos que extraigo de mis usuarios y dispositivos (vehículos)? y ¿a cuanto de su mercado puedo aspirar? McKinsey estimó hace dos años que la industria crecerá 215 mil millones de dólares, y esto sin construir más automóviles.

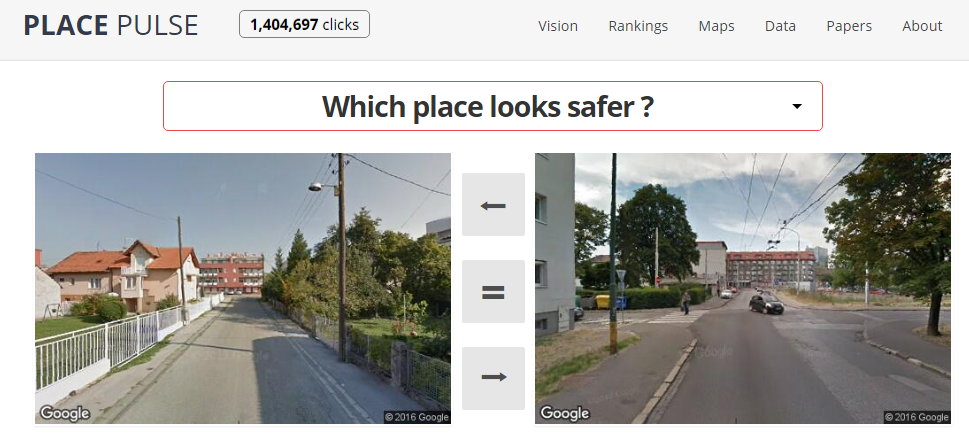

Por ejemplo un sector como el de las aseguradoras que están haciendo grandes esfuerzos y aproximaciones para competir con alguien que sabe cada kilómetro que recorre un asegurado: la distancia, el día, la hora, la meteorología, los accidentes cercanos, la ocupación de vehículo, la velocidad a la que circula, las personas con las que viaja, el motivo del viaje (fiesta, negocios?), etc. Todas son variables que en un análisis del riesgo (scoring) hace que un seguro sea más barato (menos riesgo) que otro. Pólizas de seguro a medida, no por vehículo y edad como existen ahora, sino por kilómetro, circunstancia y minuto, y en tiempo real, ajustándose a las variaciones de los parámetros según viajamos. ¿Por qué un seguro debe cobrar cuando un vehículo está aparcado en nuestro garaje? Porque sin datos deben prever las coberturas de accidentes tanto si está en uso como sino, calculando entre el grueso de sus clientes la rentabilidad global de la actividad. No pueden hacer una oferta personalizada como la que podrían estar ofreciendo si dispusieran de datos, sino un sistema en el que los justos pagan por pecadores para que las cuentas cuadren a final de año. Los seguros van a tener más difícil que un fabricante de vehículos el acceso a estos datos durante la conducción. Una vez más, quien tiene el contacto con el usuario y el cliente final tiene el control del negocio, y en pocos años serán los OEM los que controlen este contacto.

¿Puede el fabricante de automóviles, que conoce todos nuestros movimientos y rutinas, convertirse en quien abastezca energéticamente a nuestros vehículos? Calculando los consumos, distancias, desplazamientos podría ofertar tarifas planas para abastecer de energía eléctrica a sus clientes conductores, incluso ofrecerles puntos de carga a los que estamos poco acostumbrados hasta ahora: cargadores de vehículos en los parking de los supermercados mientras hacemos la compra, en la universidad mientras estamos en clase, en el museo, en la playa ¿en una propiedad privada? ¿Quien es el único que sabe cuántos conductores, y a qué hora, y con cuánta recurrencia pasan por allí con los depósitos de electricidad llenos o vacíos?

Un vehículo que tiene absolutamente todo medido y calculado (y está en red con decenas de miles de vehículos y dispositivos) sabe si una ruta es más o menos económica, rápida o cómoda porque sabe el tráfico que hay, la velocidad a la que se puede viajar, y las alternativas. ¿Pagarías 5 euros por ahorrarte 7 en un desplazamiento? ¿Cambiarías de ruta si te ofrecen “llenar” el depósito al 50% porque hay un sobrante de energía en un determinado lugar en un determinado momento? Una vez más el vehículo intermediaría entre la oferta y la demanda y sería quien haría la reserva del servicio y por último, el pago (otra intermediación conseguida en una industria indirecta: la banca).

De igual forma actuaría con los mantenimientos, al identificarnos como usuario al entrar en un automóvil, automáticamente va a conocer nuestras configuraciones, nuestros hábitos y preferencias. Conocerá por ejemplo los viajes que hemos realizado anteriormente, los destinos habituales, el número de paradas. Y puede ofrecer un servicio de mantenimiento personalizado, en base a la probabilidad más alta de ser contratado por esa persona en ese momento y en ese lugar.

Podría llegar a ofrecernos música y contenidos audiovisuales (videos, podcast…) Conocería la música que habitualmente escuchamos cuando estamos viajando. Al usuario podría interesarle contratar temporalmente un servicio de streaming durante el trayecto, con una intermediación entre un Spotify o Apple Music y el viajero, y cobrándole una tasa por el tiempo de escucha de la música, vídeo, etc.

¿Podría un OEM de automoción atacar otros negocios como el de la economía colaborativa, tipo UBER, Blablacar, etc…? ¿Podría intermediar en el transporte de personas y cargas en vehículos entre empresas y particulares? Si UBER, Blablacar, Airbnb están funcionando es gracias a los datos que consigue durante la prestación de sus servicios, y la interacción digital con los mismos. No olvidemos que los fabricantes de automóviles van a ser los mejor posicionados para obtener estos datos, con opciones, si lo hacen bien, de apropiarse del negocio del alquiler, el carsharing, el free-car y cuanto modelo esté en contacto con el desplazamiento, la movilidad, los viajes….

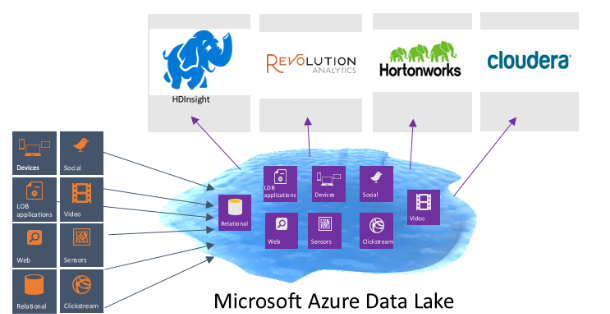

Con datos, solo hay que echarle imaginación y hacer números… y usar las tecnologías Big Data.